Cuatro estudiantes de la sede Esquel de la Universidad Nacional de la Patagonia San Juan Bosco (UNPSJB), en la provincia de Chubut, desarrollaron un prototipo de aplicación para traducir lengua de señas a audio y texto y así facilitar la comunicación para personas hipoacúsicas.

La app, a la que bautizaron SOLIDX, fue una idea de John Franco Hughes, Eric Vincon, Valentín Roo y Alen Vinay, alumnos de la tecnicatura de Analista Programador Universitario.

El prototipo funciona en base a una inteligencia artifical que entrenaron los cuatro estudiantes, traduce de diez a quince señas con precisión y puede sumar más.

La idea de los jóvenes esquelenses es seguir con el desarrollo del modelo para que pueda ser utilizado en equipos de escritorio, web o móviles.

Chubut: una charla, el disparador

Un encuentro fortuito de John Hugues durante un día en su trabajo tomando los estados de los medidores de electricidad fue el punto de partida para el invento.

Un vecino de Esquel se puso a conversar con él y en un momento le contó que su hijo era hipoacúsico y usaba un audífono eléctrico que lo ayudaba a escuchar, pero que no había encontrado ninguna aplicación que tradujera lengua de señas.

Esa misma tarde, el grupo tomó la decisión de avanzar en esa idea como trabajo final de Laboratorio y Lenguaje de Programación, una materia en la que tienen que experimentar con tecnologías buscando la innovación.

“En un principio estábamos convencidos de que íbamos a hacer un videojuego, que solo tuviera cierto tipo de complejidad inteligente y que fuera entretenido, pero después, charlando y analizando otras alternativas de proyecto, decidimos hacer algo que pueda tener un impacto social y resolver un problema”, le contó John al medio local Adnsur.

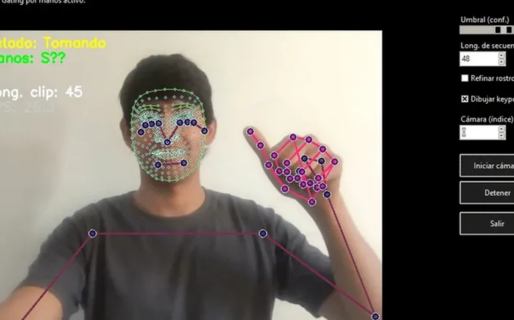

Para su app, combinaron las tecnologías de visión por computadora y redes neuronales artificiales.

“La visión por computadora es un campo de la inteligencia artificial que permite a las computadoras ‘ver’ e interpretar imágenes y videos, mientras que las redes neuronales son la rama de la inteligencia artificial que procesa datos y reconoce patrones complejos en esos datos visuales”, detalló el estudiante.

“En este caso, lo que tomamos de la realidad son señas”, agregó. “ Los datos tomados por la cámara fluyen a través de modelos matemáticos de inteligencia artificial que aprenden patrones una vez que los entrenamos”, continuó el chubutense.

Así hicieron que su sistema identificara puntos clave del cuerpo, como el rostro, el torso y las manos, para después ir almacenando y creando una base de datos propia.

“Esto es clave -señaló John- porque siempre se dice que la inteligencia artificial usa datasets ya hechos y acá empezamos desde cero”.

Con la ayuda de YouTube

Además de tener que llevar a la práctica el conocimiento adquirido, los estudiantes tuvieron que afrontar otro reto: el de aprender lengua de señas.

Para eso apelaron a lo que probablemente haría cualquiera en su situación: videos de YouTube, con los que adquirieron un conocimiento básico para avanzar con el desarrollo y entrenar a la IA.

“La idea ahora es seguir porque es un proyecto que tiene gran potencial y mucho impacto social, más que nada porque resuelve un problema que muchas personas tienen en toda la provincia y en todo el país”, subrayó John.

Con información de LM Neuquen